Como anfitrión de la XXII Edición del Carnaval de la Física, no podía faltar una participación nuestra en este evento. En esta ocasión les hablaré de cómo las radiaciones ionizantes pueden usarse en beneficio de la salud de las personas, sobre todo en el diagnóstico y tratamiento del cáncer.

Como anfitrión de la XXII Edición del Carnaval de la Física, no podía faltar una participación nuestra en este evento. En esta ocasión les hablaré de cómo las radiaciones ionizantes pueden usarse en beneficio de la salud de las personas, sobre todo en el diagnóstico y tratamiento del cáncer.

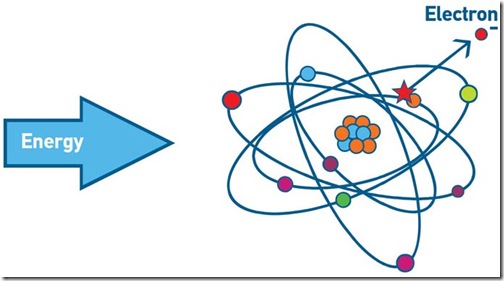

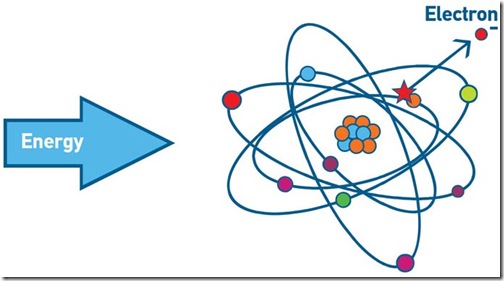

De manera sencilla, las radiaciones ionizantes engloban tanto a las ondas electromagnéticas como a las partículas atómicas que, gracias a la energía que portan, tienen la capacidad de ionizar —desprender un electrón— de cualquier átomo o molécula. Entre las más conocidas tenemos los rayos UV, cuya fuente principal es el sol y tiene la capacidad de dañar el ADN; es por esta razón que también son usadas para esterilizar las cámaras de flujo laminar y las cabinas de bioseguridad en los laboratorios. Luego tenemos los rayos gamma, los cuales también son ondas electromagnéticas generados en el universo (Ej.: estrellas, supernovas, cuásares, etc.) y en la Tierra gracias al decaimiento de los átomos radiactivos como el Uranio, los cuales pueden ser usados para esterilizar alimentos enlatados y materiales quirúrgicos, así como también pueden ser usados como trazadores en la industria y en la medicina. Los rayos alfa y beta, a diferencia de los anteriores, son partículas atómicas (electrones, positrones y núcleos de helio) que son usados en el tratamiento de ciertos tumores y cánceres. Y finalmente tenemos a los neutrones usados para la activación y conversión de átomos estables en átomos radiactivos.

El peligro de las radiaciones ionizantes se debe a su capacidad de dañar las biomoléculas que componen las células, principalmente el ADN, generando mutaciones y el desarrollo de tumores y cánceres. Cuando una biomolécula como el ADN o una proteína se ioniza, se vuelve inestable y altamente reactiva, con la capacidad de interactuar con otras moléculas, causando un daño irreversible. Es este efecto perjudicial sobre las células el que ha sido visto como un potencial aniquilador de las células malignas. Pero, para que ello funcione, la radiación debe depositarse exclusivamente en el tejido dañado para no afectar las células sanas. ¿Cómo se logra esto?

Las formas mas antiguas de tratamiento con radiaciones ionizantes (radioterapia) se basan en el uso de agujas radiactivas, usando principalmente radionúclidos con altas energías como el Cobalto-60 (Co-60) o el Cesio-137 (Cs-137), los cuales se introducían en el cuerpo del paciente hasta alcanzar el tumor. Una variante es la braquiterapia, en la cual se usa una pequeña fuente altamente radiactiva que es introducida y depositada en el tumor. Esta técnica es usada para el tratamiento del cáncer de próstata y mama, pero por ser un método invasivo es sumamente incómodo, tal como lo pueden ver en la imagen.

Las formas mas antiguas de tratamiento con radiaciones ionizantes (radioterapia) se basan en el uso de agujas radiactivas, usando principalmente radionúclidos con altas energías como el Cobalto-60 (Co-60) o el Cesio-137 (Cs-137), los cuales se introducían en el cuerpo del paciente hasta alcanzar el tumor. Una variante es la braquiterapia, en la cual se usa una pequeña fuente altamente radiactiva que es introducida y depositada en el tumor. Esta técnica es usada para el tratamiento del cáncer de próstata y mama, pero por ser un método invasivo es sumamente incómodo, tal como lo pueden ver en la imagen.

Con los grandes avances en los campos de la física y la química en los años 1950’s, donde se empezaron a producir átomos radiactivos de manera artificial (usando reactores nucleares), se entró en una nueva era para el diagnóstico y tratamiento de enfermedades conocida como la medicina nuclear.

Inicialmente se usaban los átomos radiactivos de manera pura. Por ejemplo, el Iodo-131 (I-131) era administrado directamente en un paciente para tratar sus problemas de tiroides (hipertiroidismo o cáncer de tiroides), gracias a que el Iodo tiene una gran afinidad por este órgano. Todos los isótopos de un determinado elemento tienen las mismas propiedades químicas, sean o no sean radiactivos. Si bien la diferencia entre el Iodo natural (I-127) y el I-131 son sólo cuatro neutrones de más, ambos tienen la misma afinidad por la tiroides y se comportan de la misma manera en el cuerpo humano. Así que se aprovechó de esta propiedad y especificidad por un determinado tejido para usarlo como agente terapéutico.

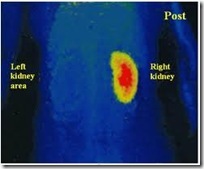

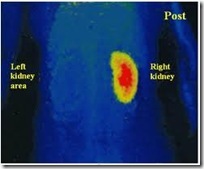

Sin embargo, los científicos se dieron cuenta que la radiación no sólo se podía usar para matar las células, ya que si se administraba a bajas actividades —como para que el daño en las células sea el mínimo— y se usaba un aparato que detecte la radiación emitida por el radioisótopo, se podía usar con fines de diagnóstico. A través del detector de radiación se podría observar cómo funcionaba un determinado órgano. Fue así como nació la gamagrafía. El Iodo radiactivo era usado para diagnosticar problemas de tiroides; el Hierro radiactivo (Fe-59) —el cual podía introducirse en la hemoglobina— fue usado para el diagnóstico de problemas sanguíneos como la policitemia (exceso de glóbulos rojos).

Con el tiempo empezaron a aparecer muchos más isótopos radiactivos de una serie de elementos diferentes, cada uno con propiedades fisicoquímicas especiales. Pero, la primera revolución en la medicina nuclear fue cuando los investigadores empezaron a unir los átomos radiactivos a una serie de moléculas sencillas que tenían afinidad por ciertos tejidos, transportando así la radiación hacia regiones y órganos específicos del cuerpo y ampliando la gama de enfermedades que podían diagnosticarse usando la radiación. Fue así como nacieron los radiofármacos allá por los años 1960’s.

Por ejemplo, una molécula sencilla como el pirofosfato (PPi) tenía una alta afinidad por los huesos. Así que cuando lo unían a un radionúclido, se podía diagnosticar problemas asociados a los huesos como: deformaciones, fracturas, cánceres, etc. Otra molécula más compleja como el ácido dietilen-triamino-pentaacético (DTPA) —el cual es una extensión del conocido agente quelante EDTA— tiene una especificidad por los riñones y al ser unido a un radionúclido es usado para evaluar la función renal. Con el paso de los años empezaron a aparecer más moléculas con afinidad por diferentes tejidos.

Por ejemplo, una molécula sencilla como el pirofosfato (PPi) tenía una alta afinidad por los huesos. Así que cuando lo unían a un radionúclido, se podía diagnosticar problemas asociados a los huesos como: deformaciones, fracturas, cánceres, etc. Otra molécula más compleja como el ácido dietilen-triamino-pentaacético (DTPA) —el cual es una extensión del conocido agente quelante EDTA— tiene una especificidad por los riñones y al ser unido a un radionúclido es usado para evaluar la función renal. Con el paso de los años empezaron a aparecer más moléculas con afinidad por diferentes tejidos.

Pero fue el descubrimiento del Tecnecio —el único de los elementos químicos tradicionales de la tabla periódica que no se encuentra de manera natural— la mayor revolución de la medicina nuclear del siglo XX. Para los años 1960’s, el Tecnecio-99 metaestable (Tc-99m) ya se producía a gran escala y prácticamente reemplazó a todos los demás radionúclidos dentro de la medicina nuclear. El Tc-99m era sumamente especial y gozaba de propiedades químicas únicas. En primer lugar es un metal, por lo tanto puede ser acomplejado y transportado usando cualquier agente quelante. Además, tiene un tiempo de vida media de 6hr (cada 6 horas, su actividad se reducía a la mitad), reduciendo así la tasa de exposición del paciente. El Tc-99m tiene todos los estados de oxidación, principalmente 0, +2, +4, +5, +6 y +7. En la actualidad es el radionúclido más usado en la medicina nuclear (casi el 90%).

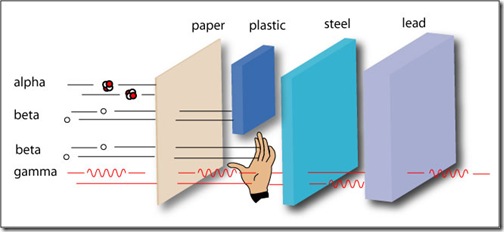

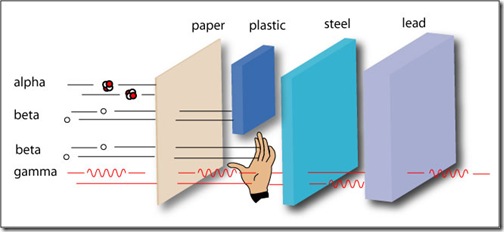

Sin embargo, el Tc-99m es un emisor de radiaciones gamma, la cual no es la más indicada si se quiere usar para el tratamiento de tumores y cánceres. Esto se debe a que la radiación gamma, por ser ondas electromagnéticas, tienen un mayor poder de penetración (pueden atravesar fácilmente cualquier material que se ponga en frente antes de depositar su carga energética), por esta razón son muy peligrosas y se requieren de blindajes de plomo para poder contenerlas (Ej.: se requiere de un bloque de plomo de 10cm para contener la radiación gama emitida por 1Ci de I-131 y de 5cm para 1Ci de Tc-99m, sin blindajes pueden atravesar una gran distancia de aire). Si se administra en actividades altas —las cuales son requeridas para matar las células malignas— afectará indudablemente a los tejidos sanos.

Por otro lado, las radiaciones beta y alfa, al ser partículas atómicas, interactuarán con mayor facilidad con la materia, es por esta razón que penetrarán una menor distancia antes de depositar su carga energética. Debido a este bajo poder de penetración, basta con una lámina de acrílico de 0.5cm o estar a una distancia de 1m para estar protegidos. Sin embargo, su efecto sobre los tejidos y las biomoléculas es de 2 a 20 veces superior al de las radiaciones gama. Entonces, ellos serán los más indicados para ser usados en la aniquilación de tumores y células malignas: la radiación afectará en mayor medida a las células que se encuentren más próximas a ellas.

Para que la radiación alfa o beta usada en el tratamiento de tumores y cánceres sea depositada sólo en el tejido dañado, debe usarse un transportador que sea sumamente específico. Las moléculas transportadoras usadas para el radiodiagnóstico tienen especificidades del 90 al 95%, o sea, entre el 5 y 10% de la radiación se no llega a su destino y se pierde en los otros tejidos, pero como las actividades usadas son bajas no generan daños perjudiciales. Este lujo no nos podemos permitir con las actividades altas de los radionúclidos usados para el tratamiento de tumores.

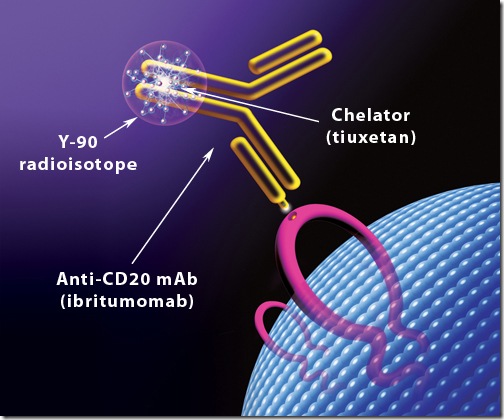

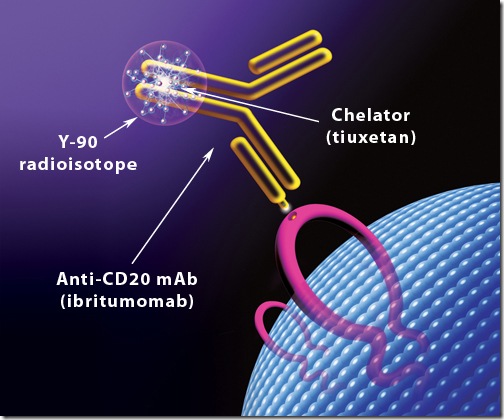

Entonces, ahora dejaremos la química para enfocarnos en la biología. ¿Cuáles son las uniones más específicas dentro de las células?. La respuesta es aquella que se da entre un anticuerpo y su antígeno respectivo o entre una molécula señalizadora y su receptor específico. Gracias a los avances en la biología celular y la inmunología se conocen una serie de antígenos y receptores específicos para cada tipo celular, muchos de ellos asociados a las células cancerosas. Entonces, basta con aislarlos y generar anticuerpos monoclonales contra ellos para usarlos como un servicio de Delivery de radionúclidos. A este proceso se le conoce como la radioinmunoterapia.

El producto más vendido del mercado para hacer la radioinmunoterapia es el Zevalin® el cual es usado para tratar linfomas (un tipo de cáncer de sangre caracterizado por la sobreproducción de células B). Este radiofármaco se basa en el uso de un anticuerpo monoclonal que reconoce un antígeno de membrana conocido como CD20, el cual se expresa solamente en las células B. El anti-CD20 (Rituximab®) es unido a un agente quelante conocido como DOTA el cual captura el radionúclido metálico —en este caso el Ytrio-90— el cual es un emisor exclusivo de radiación beta. El anti-CD20 transportará de manera específica la radiación beta a las células B malignas y terminará por exterminarlas eficientemente.

Sin embargo, al ser un emisor exclusivo de radiación beta no puede ser monitoreado para ver si el radiofármaco está dirigiéndose a la zona requerida o si se ha desviado hacia otro tejido, ya que se necesita la radiación gama para detectarlos. Además, la radiación gama permite determinar la tasa de dosis a la que está expuesto el paciente y determinar la actividad requerida para el tratamiento. Por esta razón, antes de inyectarse el Zevalin® se usa otro radionúclido con propiedades similares al Ytrio pero que emita además radiación gama. El más usado es el Indio-111.

Para ahorrarnos este trabajo se están empezando a usar otros emisores de radiación beta, los cuales también emiten una determinada cantidad de radiación gama. El más indicado para este trabajo es el Lutecio-177 (Lu-177), el cual viene reemplazando al Ytrio-90 en los últimos años.

Yo he trabajado por mucho tiempo en el desarrollo de un Anti-CD20 marcado con Lu-177, así que les comentaré brevemente como se desarrolla este radiofármaco. Lo primero es conjugar el agente quelante —en este caso el DOTA— con el anticuerpo. Luego, añadir el Lu-177 y dejar que el DOTA lo capture. Finalmente purificar el radiofármaco para separarlo del Lu-177 que haya quedado libre, ya que este radionúclido, por ser un lantánido, tiene una alta afinidad por los huesos pudiendo generar daños no deseados.

Si bien se ve fácil y rápido el proceso, es una tarea sumamente complicada. Trabajar con proteínas es muy difícil ya que si no se dan las condiciones adecuadas de pH, temperatura o concentración de sales y cofactores, simplemente la proteína se desnaturaliza, forma agregados y pierde su especificidad. Los anticuerpos son extremadamente sensibles a estas condiciones y los metales, por su parte, requieren de pH ácidos para no pasar a un estado coloidal. Cuando el metal pasa a un estado coloide, precipita y no puede ser capturado por el agente quelante, por so es recomendable hacer la marcación en una solución ácida. Pero, si se trabaja a pH ácidos la proteína tiende a desnaturalizarse. En otras palabras estas como Pimpinela: “entre la espada y la pared” sin saber si proteger a la proteína o al radionúclido.

Debido a esto, en los últimos años se están cambiando los anticuerpos por moléculas más pequeñas pero altamente específicas como los péptidos, los cuales son mas resistentes a las altas temperaturas y a pH básicos o ácidos. Por ejemplo, uno de los más usados es es el Tyr3-Octreotate (TATE), el cual es reconocido por los receptores de somatostatina, ya que es un análogo a este neurotransmisor. El TATE al ser unido a un radionúclido como el Lu-177, puede ser usado para el tratamiento de cánceres en órganos con funciones endocrinas —ricos en receptores de somatostatina— tales como el páncreas o las glándulas suprarrenales. [El cáncer de páncreas es uno de los más fulminantes de todos, las esperanzas de vida una vez diagnosticados no exceden los tres meses].

Y para terminar, una novedosa tecnología está reemplazando al Tc-99m por un radionúclidos emisores de positrones, tales como el Flúor-18 o el Iodo-121. La tecnología PET (tomografía por emisión de positrones) permite observar el funcionamiento de un órgano específico en tiempo real. No abordaré el tema por no prolongar más la presente entrada y porque Cuentos Cuánticos lo explicó para el presente Carnaval de la Física.

Espero no haberlos aburrido y perdonen la extensión de la entrada.

Por cierto, esta entrada también participa en el VII Carnaval de la Química celebrado en FeelSynapsis.

D’Costa, V., King, C., Kalan, L., Morar, M., Sung, W., Schwarz, C., Froese, D., Zazula, G., Calmels, F., Debruyne, R., Golding, G., Poinar, H., & Wright, G. (2011). Antibiotic resistance is ancient Nature DOI: 10.1038/nature10388