Actualización (22/09/2011; 23:20) Artículo científico publicado en el portal ArXiv.org:

http://arxiv.org/ftp/arxiv/papers/1109/1109.4897.pdf

Vía | Cuentos Cuánticos.

Esta tarde, todos los medios de comunicación del mundo han hecho eco de la noticia de un trabajo realizado por físicos del Centro Europeo de Investigación Nuclear (CERN) y del Laboratorio Nacional del Gran Sasso, el cual sugeriría que los neutrinos podrían viajar a velocidades superiores a la de la luz, amenazando la universalidad de la Teoría Especial de la Relatividad que propuso Albert Einstein hace más de 100 años, la cual establece que la velocidad de la luz en el vacío es la cosa más rápida del universo y nada ni nadie la puede superar, siendo la base de la Física Moderna que hoy manejamos.

Yo sugiero que se tome esta noticia con mucha cautela a pesar que la mayoría de los medios de comunicación se empecinen en mostrarlo como prueba contundente (sensacionalismo). En primer lugar porque el trabajo no ha sido publicado en una revista científica, así que se sabe muy poco o nada del diseño experimental empleado, los controles usados para contrastar los resultados y la forma cómo se han analizado los datos. Si el estudio no es publicado, pasando por las revisiones de expertos en el tema y la reproducción de los datos en otros centros de investigación, la noticia no tiene validez científica alguna. Aunque, los autores del estudio han manifestado que pondrán el artículo para su revisión previa en el portal ArXiv.org.

Yo sugiero que se tome esta noticia con mucha cautela a pesar que la mayoría de los medios de comunicación se empecinen en mostrarlo como prueba contundente (sensacionalismo). En primer lugar porque el trabajo no ha sido publicado en una revista científica, así que se sabe muy poco o nada del diseño experimental empleado, los controles usados para contrastar los resultados y la forma cómo se han analizado los datos. Si el estudio no es publicado, pasando por las revisiones de expertos en el tema y la reproducción de los datos en otros centros de investigación, la noticia no tiene validez científica alguna. Aunque, los autores del estudio han manifestado que pondrán el artículo para su revisión previa en el portal ArXiv.org.

Entrando en la historia, los físicos que trabajan en el experimento OPERA, un sofisticado detector de partículas de 1,300 toneladas métricas alojado a 1.4Km bajo tierra en el Laboratorio Nacional del Gran Sasso (Italia), estudiaron los neutrinos disparados desde el CERN, ubicado a 730Km de distancia. Durante los últimos meses, repetían y repetían el mismo experimento porque los resultados que obtenían parecían salir de toda lógica. Resulta que los neutrinos disparados desde el CERN arribaban 60 nanosegundos (ns) antes de lo que se esperaría si estos alcanzaran la velocidad de la luz (299,792,458m/s).

Los neutrinos son una de las partículas subatómicas más esquivas para los físicos ya que, a parte de tener una masa prácticamente insignificante, casi ni interactúan con la materia. Los neutrinos son producidos en todo momento por las estrellas, producto de las reacciones nucleares que se llevan a cabo dentro de ellas. Nuestro planeta también produce neutrinos por el decaimiento radiactivo de los elementos que la conforman. Cada segundo nos atraviesan millones de ellos, y nos traspasan como si no existiéramos. Es por esta razón que los detectores de neutrinos deben ubicarse cientos de metros bajo tierra, donde los otros tipos de rayos cósmicos ya no puedan penetrar más, y reducir el fondo de lectura al mínimo. Luego queda esperar que al menos uno de los millones de neutrinos que pasan cada segundo interaccione con el detector.

En los tres años que lleva el experimento, OPERA ha detectado unos 16,000 neutrinos muónicos disparados por el Súper Sincrotrón de Protones del CERN. Los físicos calcularon que si los neutrinos alcanzan la velocidad de la luz, deberían tardar 2.43 milisegundos en atravesar los 730Km que separan a estos dos centros de investigación. Sin embargo, en promedio, los neutrinos alcanzaban al detector del OPERA 60ns antes de lo esperado, con una incertidumbre de 10ns.

Si bien no soy físico nuclear experto en neutrinos, el comunicado de prensa del estudio me ha generado ciertas preguntas. En primer lugar, para calcular estas pequeñas cantidades de tiempo de manera precisa se necesitan de relojes sumamente sofisticados y exactos. Los investigadores dicen haber usado el Sistema de Posicionamiento Global (GPS) para calcular la distancia y los tiempos, gracias a que estos cuentan con relojes atómicos —los más precisos desarrollados hasta ahora. Sin embargo, según la Teoría de la Relatividad (que irónicamente, el estudio estaría por desmoronar), los relojes atómicos se retrasan debido a la gran velocidad a la que orbitan los satélites que los transportan. Si bien este atraso es insignificante, puede ser significativo cuando se trata de medir tiempos en nanosegundos, así que los 10ns de incertidumbre podrían estar subestimados.

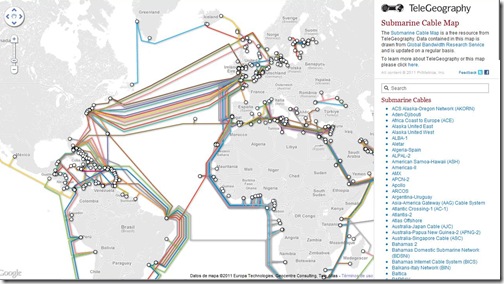

Otra observación que hago es referente a la tecnología empleada. Nuestra tecnología esta restringida por las propiedades físicas de los materiales que usamos en los dispositivos electrónicos. Esto quiere decir que la información que se transmite por los cables de fibra óptica y vía satelital, o los que viajan por los circuitos integrados y materiales semiconductores de los dispositivos electrónicos, no supera nunca la velocidad de la luz, así que sería muy difícil detectar algo que viaje más rápido que ella, y la incertidumbre puede ser mucho mayor. No se si mi lógica este bien planteada.

¿Cómo se sabe en qué momento partió un determinado neutrino desde el CERN y cómo se tiene la seguridad de que ese mismo neutrino fue el detectado en OPERA?. En el mundo de la física nuclear y la física de partículas todo se maneja por estadísticas y probabilidades, y no de manera individual. Además, ¿cómo se puede diferenciar a los neutrinos del CERN de los neutrinos que vienen del espacio?. Me imagino que es en base a su energía o al tipo de neutrino que son generados por el CERN.

Si los neutrinos viajaran más rápido que la luz, tal vez nos hubiéramos dado cuenta de ello hace algunos años atrás. Cuando una estrella colapsa y estalla convirtiéndose en una gran supernova, desprende una gran cantidad de partículas subatómicas (rayos cósmicos), generando una gran cantidad de neutrinos. Entonces, pongamos el caso del la Supernova 1987A, la cual estaba —en el año 1987— a unos 168,000 años luz de distancia de la Tierra. Si en 730Km, el neutrino arribó 60ns antes de lo que lo hubiera hecho la luz; entonces, a una distancia de 168,000 años luz (1,5 x 1015Km), los neutrinos hubieran arribado a la Tierra casi 4 años antes de haber observado la explosión de la estrella. Sin embargo, ambos llegaron casi al mismo tiempo.

Finalmente, si los neutrinos viajan más rápido que la luz, se debería observar evidencias de algún tipo de efecto Cherenkov, el cual es un tipo de onda de choque que se genera cuando una partícula viaja más rápido que la luz.

En fin, solo queda esperar que el artículo se publique, pero ayudarían de mucho los comentarios de los físicos, quienes son más conocedores del tema, para poder resolver algunas de estas interrogantes.

…(Bonus Track)…

Para terminar me voy a permitir “plantear una teoría” un poco loca [bueno, dentro del mundo de la física de partículas, cualquier cosa es posible]. Partículas que viajen más rápido que la luz existen, pero sólo bajo cierto tipo de condiciones. Por ejemplo, tal vez no todos han tenido la posibilidad de observar el núcleo de un reactor nuclear trabajando a máxima potencia. Si no lo han visto se ve más o menos así:

Es de color azul intenso, muy bonito. A esto se le conoce como el efecto Cherenkov. Este fenómeno se da porque el material combustible de los reactores nucleares (las varillas portando el Uranio) se encuentran sumergidos en una gran piscina de agua, de unos 10 a 15 metros de profundidad. Resulta que en el agua, la luz reduce su velocidad hasta en un 25%. Sin embargo, las partículas cargadas liberadas por la fisión nuclear se desprenden a una velocidad que logra superar a la de la luz, formándose una onda de choque. Por ejemplo, cuando un avión supersónico rompe la barrera del sonido, la onda de choque genera un fuerte estruendo. De la misma forma, cuando una partícula cargada viaja más rápido que la luz, la onda de choque genera una hermosa radiación luminosa azul.

Ahora veamos el espacio, no como un lugar vacío [que no podamos ver nada no significa que no haya nada]. El espacio interestelar está lleno de partículas conocidas como rayos cósmicos, por ejemplo, protones, neutrones, núcleos de helio, electrones, etc.; así como también, puede estar llena de la hipotética materia oscura, todas ellas con masa. En otras palabras, el espacio interestelar es un medio lleno de partículas, al igual que el agua o el aire.

Entonces, tal vez la velocidad de la luz “en el completo vacío” sea mucho mayor a los 299,792,458m/s que hoy se establece. Pero, debido a la presencia de estas partículas, la velocidad de la luz se reduce, haciéndonos creer que ésta es la velocidad máxima que puede alcanzar, cuando en realidad no lo es. Sin embargo, como los neutrinos prácticamente no interactúan con la materia, no se ven afectados por la presencia de estas partículas, ya sea en el espacio o en la Tierra, así que su velocidad podría ser mayor a la velocidad de la luz en el espacio (el cual se cree que es vacío), pero no será mayor que en el vacío real (cuyo valor desconocemos por ahora).

Bueno, creo que se me han quemado los chicotes, eso me pasa por entrometerme en temas que no me incumben. Así que los físicos que hayan leído hasta este punto, perdonen el atrevimiento de este biólogo.

![iphone[1] iphone[1]](http://lh4.ggpht.com/-ksJJfNznuA4/ToVEfwwrCTI/AAAAAAAAASw/5DrY_KtwYGo/iphone%25255B1%25255D_thumb%25255B9%25255D.jpg?imgmax=800) La aplicación consistía en mostrar en la pantalla del celular un estímulo —una palabra bien escrita o una mal escrita (sin sentido)— que el usuario debía identificar si era o no una palabra. Para determinar la velocidad de respuesta, el estímulo era mostrado tan sólo por 0.3 segundos. El usuario podía elegir entre 50, 100 y 140 estímulos, dependiendo de su tiempo. Además, algunos de los estímulos mostrados se repetían con una mayor frecuencia.

La aplicación consistía en mostrar en la pantalla del celular un estímulo —una palabra bien escrita o una mal escrita (sin sentido)— que el usuario debía identificar si era o no una palabra. Para determinar la velocidad de respuesta, el estímulo era mostrado tan sólo por 0.3 segundos. El usuario podía elegir entre 50, 100 y 140 estímulos, dependiendo de su tiempo. Además, algunos de los estímulos mostrados se repetían con una mayor frecuencia. Dufau, S., Duñabeitia, J., Moret-Tatay, C., McGonigal, A., Peeters, D., Alario, F., Balota, D., Brysbaert, M., Carreiras, M., Ferrand, L., Ktori, M., Perea, M., Rastle, K., Sasburg, O., Yap, M., Ziegler, J., & Grainger, J. (2011). Smart Phone, Smart Science: How the Use of Smartphones Can Revolutionize Research in Cognitive Science PLoS ONE, 6 (9) DOI: 10.1371/journal.pone.0024974

![nectar[4] nectar[4]](http://lh4.ggpht.com/-Oxhiic4umJg/ToMHvjTm2zI/AAAAAAAAASY/Sa2OTl7vZ34/nectar%25255B4%25255D_thumb%25255B11%25255D.jpg?imgmax=800)

Las bacterias son cultivadas en placas de dilución en un medio líquido (caldo de cultivo) y con un replicador se imprime 0.1ul de cada una en un medio sólido (agar). Una vez que las colonias crezcan son transferidas en una membrana de nitrocelulosa, el mensaje quedará impreso en ella. Esta lámina se envía al destinatario quien hará el proceso inverso, imprimiendo la membrana en otro medio de cultivo sólido enriquecido con los factores adecuados para la expresión de las proteínas fluorescentes.

Las bacterias son cultivadas en placas de dilución en un medio líquido (caldo de cultivo) y con un replicador se imprime 0.1ul de cada una en un medio sólido (agar). Una vez que las colonias crezcan son transferidas en una membrana de nitrocelulosa, el mensaje quedará impreso en ella. Esta lámina se envía al destinatario quien hará el proceso inverso, imprimiendo la membrana en otro medio de cultivo sólido enriquecido con los factores adecuados para la expresión de las proteínas fluorescentes.